BERT(Bidirectional Encoder Representations from Transformers)とは2018年10月にGoogleから発表された自然言語処理技術です。2019年10月に米国のGoogle検索で導入、2019年12月には日本語Google検索でも導入されたことが発表されました。

BERTの仕組み

BERTは従来の自然言語処理とどう仕組みが違うのでしょうか。

| ・Topic:そもそも「自然言語処理」とは 自然言語処理とは、人間が日常的に使用している言葉を機械に理解させるための処理のことを指します。英語では「Natural Language Processing」と呼び「NLP」と略されることもあります。 |

従来の自然言語処理では課題をこなすために、大量にラベル(目印)の付いたデータを用意する必要がありました。ラベルの付いたデータを大量に用意して処理させることで課題に対応させるという方法です。

また、文章を単方向に読んでいくことから単語の意味は理解できるものの文章全体の意図や文脈が理解できていないケースもあったのも特徴です。

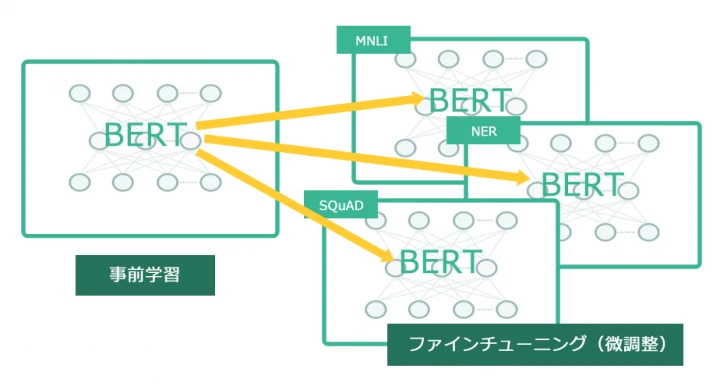

従来の方法に対し、BERTはラベルなしのデータをはじめに大量に処理させることが特徴です(事前学習)。その後、処理されたデータに“少量のラベルありデータ”を使用することによって課題に対応させます(ファインチューニング)。

この手法の優れた点は「ラベルありのデータを大量に用意しなくてもよい」といった点(従来の手法ではこの準備が大変でした)、そして従来よりも自然言語の解釈に優れているという点です。

さらに事前学習の際に文章を単方向ではなく双方向に読み、従来の単方向の読みとは異なり文章全体をより俯瞰できるようになったため、従来よりも文脈の理解が深まっていることも特長です。

参考:BERT: Pre-training of Deep Bidirectional Transformers for Language Understanding

Googleが検索エンジンにBERTを採用した背景

Googleが検索にBERTを導入した理由は、この仕組みがコンテンツの文脈を読むことに非常に優れており、検索結果が大幅に改善されるためです。

特に近年増加しているスマートフォンやスマートスピーカーから入力される会話(音声)型クエリや複雑なクエリなどを理解しやすくなることが特長で、検索に導入された際、「過去5年で飛躍的に検索クエリに対しての理解が深まった」「米国の英語検索の約10%が改善された」といったデータも公表されています。(※)

※

we’re making a significant improvement to how we understand queries, representing the biggest leap forward in the past five years, and one of the biggest leaps forward in the history of Search.

※

In fact, when it comes to ranking results, BERT will help Search better understand one in 10 searches in the U.S. in English, and we’ll bring this to more languages and locales over time.

(https://www.blog.google/products/search/search-language-understanding-bert/)

BERTが検索結果にどう影響する?予想されること

BERTは会話型クエリや複雑なクエリなど細かい部分で正確に検索結果を返すようになることが特長です。以下のようなクエリが対象となるとお考えください。

| 会話型クエリの例 | 複雑なクエリの例 |

| 「質素にならずに結婚式を安くする方法を知りたい」 「旅行代理店はどういうビジネスモデルなのかをわかりやすく教えて」 「2020年以外でオリンピックが延期になったことはある?」 | 「近所でグリンピースの入っていないカレーを食べられるお店」 「九州で福岡以外の県のオススメのスポット」 「スカーフをまとめてくびに巻く(スカーフをまとめて、首に巻く/スカーフをまとめ手首に巻く)」 |

このようなクエリは、1つ1つの月間検索回数が少ないため、検索結果の変化自体は非常に気付きにくいことが想定されます。

実際にGoogleの公式ブログの検索クエリ改善事例も「2019年に米国に行くのにブラジル旅行者はビザが必要か(2019 brazil traveler to usa need a visa.)」「エステティシャンは仕事中に立っていることが多いか(do estheticians stand a lot at work.)」などロングテールよりのキーワードの変化がピックアップされています。

目に見える大変動が起こる類のものではありませんが、想定される事象についてピックアップしてみましょう。

1)よりクエリにマッチした検索結果を返すようになる

BERTが導入されることにより細かいクエリに対して検索結果の精度がより高くなります。そのためユーザー観点から見ると探したい情報がより早く見つけやすくなります。

「より早く知りたい情報を探せる」という点については、BERTがあってもなくてもGoogleの目指しているところなので、「検索の精度が上がる」程度に考えておけば問題ないでしょう。

2)ウェブサイトの検索流入の細かな増減がある

検索ユーザー側では会話型クエリや複雑なクエリで、自分の探したい情報にすぐにアクセスできるようになりますが、反対にウェブサイト側では細かいキーワードでの流入の増減が出てくる可能性があります。

ただし、より正確な検索クエリで自分のサイトに流入が増える(≒関連性の薄い検索クエリからの流入が減少する)ということなので過度に心配する必要はありません。

前述の「2019年に米国に行くのにブラジル旅行者はビザが必要か」「エステティシャンは仕事中に立っていることが多いか」の例の通り、キーワードの規模が小さなものが多いことが想定されるので気付かない程度の影響でしょう。

3)特徴的なクエリが確認できる可能性がある

前項で触れた通り、会話形クエリや複雑なクエリでの検索性能が上がることにより、ロングテールキーワードの流入が増える可能性があります。

現段階ではSearch Consoleで音声検索のクエリのみを抜き出すことは不可能ですが、細かなキーワードを追っていくと今まで確認できなかったキーワードが確認できるようになるかもしれません。

より細かいキーワードの場合、ユーザーが強く求めているものが明確に出てくることが多いため、ユーザーの欲求などが可視化しやすくなるでしょう。

大々的に発表されたBERTですが、細かなキーワードでの検索精度や内容の理解度が上がるといったものなのでウェブマスター側で特殊な対応をしなくてはいけないといったものではありません。

従来通り、ユーザーが求めている良質なコンテンツを提供することに専念しましょう。

BERTを理解する翻訳記事一覧(リンク集)

■Understanding searches better than ever before

https://www.blog.google/products/search/search-language-understanding-bert/

■はじめての自然言語処理 BERT を用いた自然言語処理における転移学習 | オブジェクトの広場

https://www.ogis-ri.co.jp/otc/hiroba/technical/similar-document-search/part3.html

■自然言語処理の「BERT」とは何か – LSC PSD – Medium

https://medium.com/lsc-psd/nlp%E3%81%AE%E7%A5%9E%E6%A7%98-bert-%E3%81%A8%E3%81%AF%E4%BD%95%E3%81%8B-b3c72f3aaabe

この記事が気になる方へ!おすすめの資料はこちら

マーケティングの教科書~SEO・Web解析編~

SATORIマーケティングブログの記事から、SEO・Web 解析にまつわる情報を一冊にまとめました。

必要な時に、必要な箇所だけを読んですぐにご活用いただけます。

2007年10月にSEOディレクターとしてSEO事業者に入社。企業サイトを中心にコンサルティングを行う。 2015年4月に独立。 メディア運営とSEOコンサルティングを中心に活動中。 個人活動として2008年にSEOの勉強と情報発信のために「バカに毛が生えたブログ」開設し、現在もSEO関連の情報を発信している。